Actu Maroc

Rétro - Verso : ELIZA, aux origines de l’Intelligence Artificielle conversationnelle

ELIZA, une IA créée dans les années 60, a bouleversé la perception de l'informatique et soulevé des questions éthiques sur l'IA.

Par Houda BELABD

mardi 29 juillet 202510 min de lecture

Fonctionnalité audio bientôt disponible

Culture

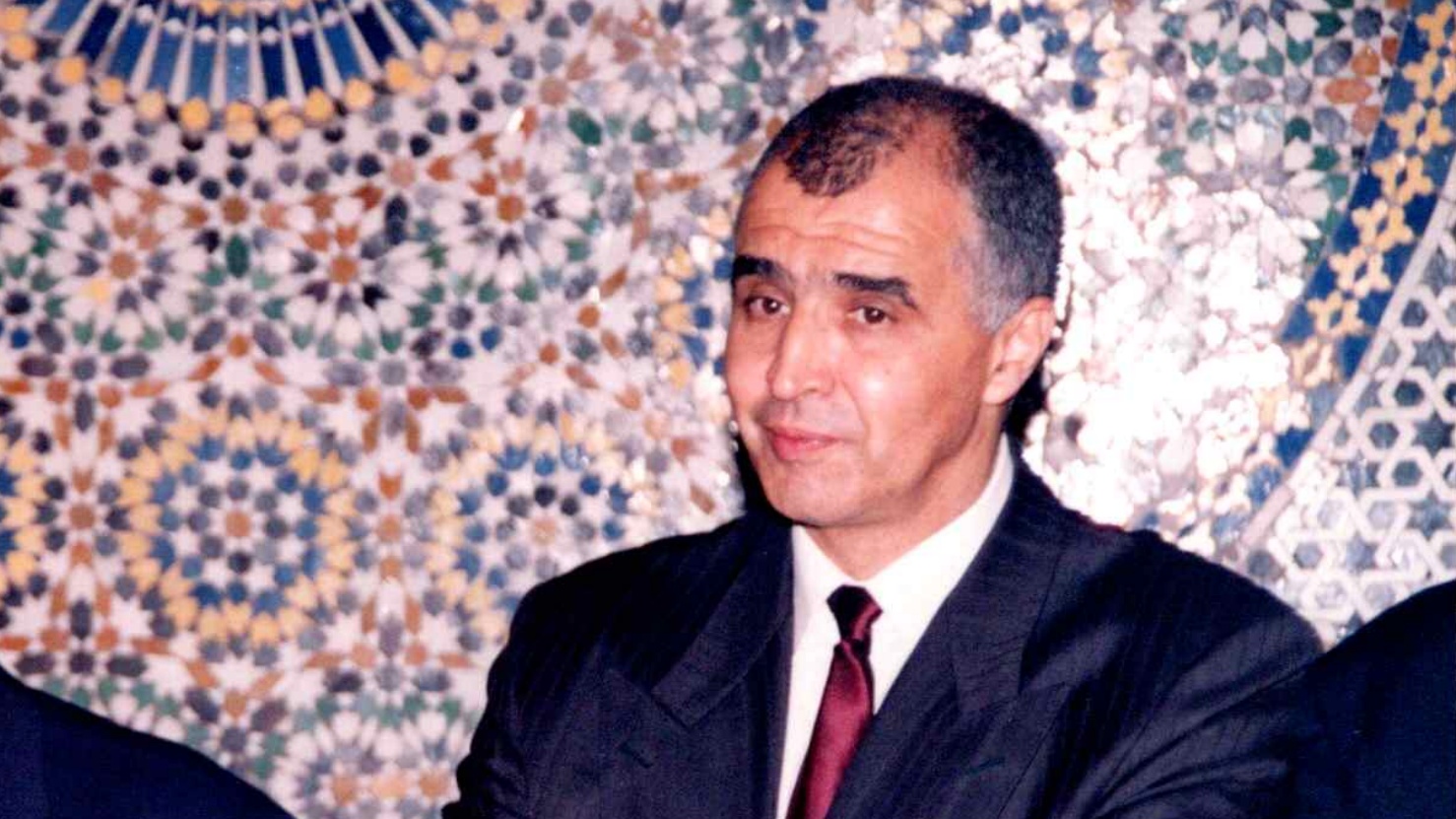

MAGAZINE : Najib Salmi, l’ultime shoot

31/01/2026|6 min de lecture

Sport

« L'Opinion » et la presse nationale en deuil… Saïd Hajjaj alias « Najib Salmi » a tiré sa révérence !

25/01/2026|2 min de lecture

Régions

Ouezzane: Lancement de projets structurants dans la cadre de la stratégie “Génération Green”

31/12/2025|2 min de lecture

Ad

Régions

Tanger-Tétouan-Al Hoceima: les retenues des barrages dépassent 1 milliard de m3

31/12/2025|2 min de lecture

Régions

Essaouira: Une destination Nikel pour passer des vacances magiques !

31/12/2025|1 min de lecture

Régions

Ali Mhadi, nommé nouveau chef de la police judiciaire à El Jadida

31/12/2025|1 min de lecture