Ce questionnement invite à un changement de perspective. Il ne s’agit plus simplement de superviser un outil, mais de gouverner une transformation. Car l’IA, loin d’être un objet technique neutre, est un vecteur de réorganisation du réel : des flux de décision, des rapports de pouvoir, des formes de savoir. Elle constitue un véritable phénomène numérique, au sens où elle participe à la reconfiguration des systèmes cognitifs, économiques et sociaux.

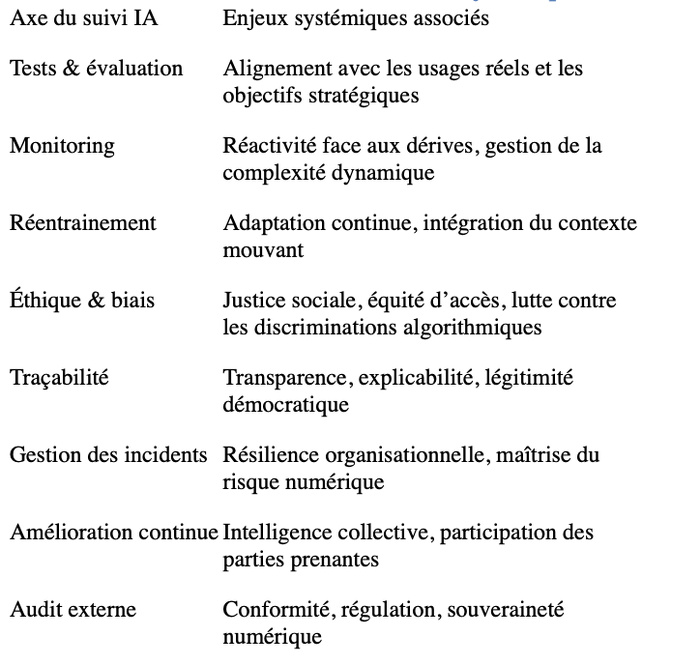

Le tableau de suivi des modèles d’IA que nous proposons, fondé sur l’évaluation, la traçabilité, l’amélioration continue ou encore l’audit externe, n’est pas un simple instrument de contrôle. Il s’inscrit dans une vision plus large : celle d’un changement de paradigme qui articule technologie, éthique, gouvernance et souveraineté.

Le tableau de suivi des modèles d’IA que nous proposons, fondé sur l’évaluation, la traçabilité, l’amélioration continue ou encore l’audit externe, n’est pas un simple instrument de contrôle. Il s’inscrit dans une vision plus large : celle d’un changement de paradigme qui articule technologie, éthique, gouvernance et souveraineté.

Tableau de suivi des modèles IA – Lecture systémique

La supervision d’un modèle IA devient alors une fonction vitale. Non pour encadrer un dispositif fermé, mais pour accompagner un système vivant, évolutif, interactif. Les tests de performance doivent ainsi être conçus non comme une validation ponctuelle, mais comme une dynamique continue d’alignement entre les finalités poursuivies, les données mobilisées, les contextes d’usage, et les retours des utilisateurs. Le monitoring, de son côté, ne vise pas uniquement à détecter des dérives techniques, mais à interroger les effets systémiques d’un algorithme sur les trajectoires sociales, sur la distribution des opportunités, sur la perception de la légitimité des décisions.

Dès lors, la performance d’un modèle IA ne peut plus être pensée comme un simple rendement. Elle doit être replacée dans une logique de performance systémique : une capacité du système global (modèle, contexte, acteurs, données) à générer des résultats pertinents, justes, explicables et adaptés aux objectifs réels.

Ce changement de paradigme exige également un déplacement des responsabilités. L’IA ne peut être confiée à un seul profil technique. Elle doit être portée par des équipes pluridisciplinaires, impliquant des data scientists, mais aussi des juristes, des éthiciens, des utilisateurs finaux, des décideurs publics. La gouvernance devient partagée, distribuée, évolutive. Elle requiert des comités d’éthique, des mécanismes de signalement, des audits indépendants, des formes de traçabilité lisibles.

C’est dans cette logique que nous proposons une lecture croisée du tableau de supervision avec les chapitres de notre ouvrage. Chaque axe – performance, monitoring, réentrainement, gestion des biais, auditabilité, réaction aux incidents – peut être relié à un pilier de notre pensée : l’alignement stratégique, la souveraineté cognitive, la justice algorithmique, la résilience organisationnelle, l’inclusion des usagers.

La question n’est donc plus : le modèle est-il performant ? Mais bien : à quelles conditions ce modèle reste-t-il pertinent, juste, explicable, gouvernable, utile ? Et surtout : au service de qui et de quoi est-il conçu ?

Dans les pays du Sud comme le Maroc, cette réflexion prend une dimension particulière. Trop souvent, l’importation d’outils technologiques s’accompagne d’une marginalisation des savoirs locaux et d’un effacement des contextes d’usage. Il est donc essentiel d’inventer des dispositifs de supervision qui traduisent une ambition propre : construire une IA souveraine, éthique, inclusive, enracinée.

Cela suppose une maîtrise technique, certes, mais aussi une culture numérique, une vigilance épistémologique, une vision systémique. C’est à ce prix que la performance de l’IA cessera d’être un mirage techniciste, pour devenir un levier d’émancipation, de transformation et de souveraineté partagée.

Gouverner l’IA, c’est accepter d’en faire un objet d’apprentissage collectif. C’est sortir de la fascination pour les résultats immédiats, pour entrer dans une logique d’évolution maîtrisée. Une IA véritablement performante est une IA suivie, discutée, adaptée, comprise, encadrée. Une IA vivante, mais encadrée par une vision.

Car la supervision d’un modèle IA n’est pas une tâche annexe. C’est une posture de civilisation.

Dès lors, la performance d’un modèle IA ne peut plus être pensée comme un simple rendement. Elle doit être replacée dans une logique de performance systémique : une capacité du système global (modèle, contexte, acteurs, données) à générer des résultats pertinents, justes, explicables et adaptés aux objectifs réels.

Ce changement de paradigme exige également un déplacement des responsabilités. L’IA ne peut être confiée à un seul profil technique. Elle doit être portée par des équipes pluridisciplinaires, impliquant des data scientists, mais aussi des juristes, des éthiciens, des utilisateurs finaux, des décideurs publics. La gouvernance devient partagée, distribuée, évolutive. Elle requiert des comités d’éthique, des mécanismes de signalement, des audits indépendants, des formes de traçabilité lisibles.

C’est dans cette logique que nous proposons une lecture croisée du tableau de supervision avec les chapitres de notre ouvrage. Chaque axe – performance, monitoring, réentrainement, gestion des biais, auditabilité, réaction aux incidents – peut être relié à un pilier de notre pensée : l’alignement stratégique, la souveraineté cognitive, la justice algorithmique, la résilience organisationnelle, l’inclusion des usagers.

La question n’est donc plus : le modèle est-il performant ? Mais bien : à quelles conditions ce modèle reste-t-il pertinent, juste, explicable, gouvernable, utile ? Et surtout : au service de qui et de quoi est-il conçu ?

Dans les pays du Sud comme le Maroc, cette réflexion prend une dimension particulière. Trop souvent, l’importation d’outils technologiques s’accompagne d’une marginalisation des savoirs locaux et d’un effacement des contextes d’usage. Il est donc essentiel d’inventer des dispositifs de supervision qui traduisent une ambition propre : construire une IA souveraine, éthique, inclusive, enracinée.

Cela suppose une maîtrise technique, certes, mais aussi une culture numérique, une vigilance épistémologique, une vision systémique. C’est à ce prix que la performance de l’IA cessera d’être un mirage techniciste, pour devenir un levier d’émancipation, de transformation et de souveraineté partagée.

Gouverner l’IA, c’est accepter d’en faire un objet d’apprentissage collectif. C’est sortir de la fascination pour les résultats immédiats, pour entrer dans une logique d’évolution maîtrisée. Une IA véritablement performante est une IA suivie, discutée, adaptée, comprise, encadrée. Une IA vivante, mais encadrée par une vision.

Car la supervision d’un modèle IA n’est pas une tâche annexe. C’est une posture de civilisation.